De concepttekst van het Voorstel voor een verordening over artificiële intelligentie (AI-verordening) die de Europese Commissie (EC) op 21 april 2021 publiceerde, blijft onderwerp van discussie en kritische analyses binnen de maakindustrie. Toch zijn nog niet alle maakbedrijven zich bewust van de mogelijk aanzienlijke gevolgen van dit nieuwe regelgevend kader met uitgebreide wettelijke voorschriften voor hun bedrijfsvoering. Een brede groep van marktdeelnemers in de toeleverings- en distributieketen zal direct of indirect met het voorstel voor een AI-verordening te maken krijgen. Daarnaast beoogt deze wetgeving een grote hoeveelheid verschillende (soms tegenstrijdige) belangen te behartigen en doelstellingen te bereiken.

In een eerdere blog gingen onze advocaat AI-verordening, productregelgeving & CE-markering in Amsterdam nader in op deze onderwerpen. In die blog stonden de achtergrond en totstandkoming, het doel en de noodzaak, de (specifieke) doelstellingen en een korte beschrijving van de inhoudelijke onderwerpen van het voorstel voor een AI-verordening centraal.

In dit tweede deel zal met name worden stilgestaan bij de betekenis van de huidige concepttekst en de gevolgen voor de maakindustrie van het voorstel voor een AI-verordening. Onderwerpen die aan bod komen, zijn het toepassingsbereik, de gehanteerde definitie van een AI-systeem, de zogenaamde risicogebaseerde aanpak, verboden AI-praktijken en de classificatie van AI-systemen met een hoog risico.

Wettelijke voorschriften AI-verordening: Op wie is het voorstel voor een ai-verordening van toepassing?

Onze advocaten productregelgeving en CE-markering in Amsterdam ontvangen van verschillende marktdeelnemers geregeld de vraag: op wie is het voorstel voor een AI-verordening van toepassing? In de kern geldt deze voor:

- aanbieders die AI-systemen in de EU in de handel brengen of in gebruik stellen, ongeacht of deze aanbieders in de EU of in een derde land zijn gevestigd;

- gebruikers van AI-systemen die zich in de EU bevinden;

- aanbieders en gebruikers van AI-systemen die zich in een derde land bevinden wanneer de output (gevolgen) van het AI-systeem in de EU wordt gebruikt.

Hieruit blijkt dat het voorstel voor een AI-verordening zelfs van toepassing is als bepaalde AI-systemen niet direct in de EU in de handel worden gebracht, in bedrijf worden gesteld of worden gebruikt. Achtergrond van dit brede toepassingsgebied is de digitale aard van AI-systemen.

Op een specifieke groep AI-systemen met een hoog risico is het voorstel voor een AI-verordening slechts zeer beperkt van toepassing. Hierbij gaat het om producten of systemen die vallen onder de (beveiliging van de) burgerluchtvaart, landbouw- en bosbouwvoertuigen, twee- of driewielige voertuigen en vierwielers, uitrusting voor zeeschepen, interoperabiliteit van het spoorwegsysteem in de EU en motorvoertuigen inclusief aanhangwagens en systemen, onderdelen en technische eenheden voor dergelijke voertuigen.

Het voorstel voor een AI-verordening is niet van toepassing op AI-systemen die alleen voor militaire doeleinden worden ontwikkeld of gebruikt. Ook is het voorstel niet van toepassing op overheidsinstanties in derde landen of internationale organisaties als deze AI-systemen gebruiken voor internationale samenwerking met de EU of een of meer lidstaten op het gebied van rechtshandhaving en justitie.

Wettelijke voorschriften AI-verordening – Definitie van een artificiële-intelligentiesysteem

In het voorstel voor een AI-verordening is de volgende definitie van een artificiële-intelligentiesysteem (AI-systeem) opgenomen:

“software die is ontwikkeld aan de hand van een of meer van de technieken en benaderingen die zijn opgenomen in de lijst van bijlage I en die voor een bepaalde reeks door mensen gedefinieerde doelstellingen output kan genereren, zoals inhoud, voorspellingen, aanbevelingen of beslissingen die van invloed zijn op de omgeving waarmee wordt geïnterageerd (zowel fysiek als digitaal in wisselwerking staat)”

Doel van deze brede formulering is om gelet op de snelle ontwikkelingen een technologieneutrale, toekomstbestendige en flexibele definitie te hanteren. Om toch rechtszekerheid te bieden is de verwijzing naar de lijst met technieken van bijlage I opgenomen. Deze betreft machinaal leren, op logica en kennis gebaseerde benaderingen en statistische benaderingen. Bijlage I kan door de EC op basis van toekomstige technologische ontwikkelingen worden bijgewerkt.

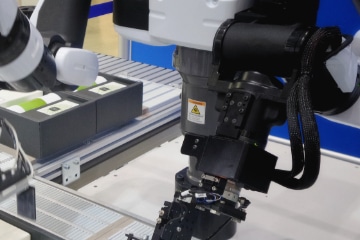

De toepassingen van AI-systemen zijn divers. AI-systemen kunnen in verschillende mate autonoom functioneren. AI-technologieën kunnen ook als zelfstandig onderdeel of als component van een product of dienst worden gebruikt. Daarnaast kunnen AI-systemen fysiek in een product worden geïntegreerd of ten dienste staan van de functionaliteit van het product zonder daarin te zijn geïntegreerd.

Enkele voorbeelden van AI-toepassingen die in de maakindustrie worden gebruikt zijn productierobots en vormen van machinaal leren zoals voorspelbaar onderhoud en technieken voor bijvoorbeeld de optimalisatie van energie- en grondstoffenverbruik, kwaliteitsinspecties en beheer van de toeleveringsketen, voorraden en risico’s.

risicogebaseerde aanpak

In het voorstel voor een AI-verordening is niet gekozen voor een algemene regeling voor alle AI-systemen, maar voor een evenredige risicogebaseerde aanpak of benadering. Dit wordt ook wel een piramidestructuur genoemd. Inhoudelijk betekent dit dat de toepasselijke regels afhankelijk zijn van de intensiteit en de omvang van het risico van het betreffende AI-systeem voor de gezondheid, veiligheid of grondrechten van personen. Op basis van het (waarschijnlijke) risico worden vier categorieën van AI-systemen onderscheiden:

- onaanvaardbaar risico;

- hoog risico;

- beperkt risico;

- minimaal risico.

AI-systemen met een onaanvaardbaar risico zijn in beginsel verboden. Voor AI-systemen met een hoog risico zijn dwingende voorschriften en verplichtingen voor de betrokken marktdeelnemers opgenomen. Met betrekking tot AI-systemen met een beperkt risico gelden transparantieverplichtingen, zoals informatieverstrekking. Een AI-systeem met een beperkt risico is bijvoorbeeld een chatbot, ook wel geautomatiseerde gesprekspartner genoemd. In het voorstel voor een AI-verordening zijn geen aanvullende eisen vastgesteld voor AI-systemen met een minimaal risico. Dit zijn bijvoorbeeld spamfilters en zoekmachines. Wel stimuleert de EC de toepassing van vrijwillige gedragscodes voor deze AI-systemen.

De eerste twee categorieën zullen hierna vanwege hun belang nader worden toegelicht.

Verboden ai-praktijken

Het voorstel voor een AI-verordening bevat een lijst met verboden AI-praktijken. Het gebruik hiervan wordt onaanvaardbaar geacht, omdat deze schadelijk zijn en strijdig met de waarden van de EU. Bijvoorbeeld de menselijke waardigheid, vrijheid, gelijkheid, democratie, rechtstaat en grondrechten. Samengevat gaat het om AI-systemen die gebruikt kunnen worden voor manipulatie, uitbuiting en sociale controle.

Subliminale technieken en kwetsbaarheden

Het in de handel brengen, in gebruik stellen of gebruiken van AI-systemen is verboden wanneer deze gebruikmaken van (i) technieken waarvan personen zich niet bewust zijn (zogenaamde subliminale technieken) of (ii) de kwetsbaarheden van personen als gevolg van leeftijd of fysieke of geestelijke handicap voor manipulatie, misbruik of uitbuiting. Het gaat dan om AI-systemen die als doel hebben het verstoren van gedrag van personen, waardoor (waarschijnlijk) fysiek of psychisch letsel ontstaat. Als personen niet aan schade worden blootgesteld en ethische normen worden nageleefd, is (wetenschappelijk) onderzoek voor legitieme doeleinden op dit gebied wel toegestaan.

Sociale controle

Daarnaast zijn AI-systemen verboden die door of namens overheidsinstanties worden gebruikt voor zogenaamde sociale scoring of sociale controle. Dit betreft het beoordelen of indelen in klassen van de betrouwbaarheid van personen op basis van hun sociale gedrag of aan de hand van bekende of voorspelde persoonlijke of persoonlijkheidskenmerken. Het gaat dan met name om situaties waarin de sociale score leidt tot een nadelige of ongunstige behandeling van personen of groepen (uitsluiting) die niet in verhouding staat met de context waarin de data werden verzameld of die ongerechtvaardigd of onevenredig is met hun sociale gedrag. Een voorbeeld is het dalen van de sociale score als gevolg van wettelijke overtredingen, waardoor de mogelijkheid om een lening van een bank te verkrijgen wordt beperkt of de toegang tot openbare diensten zoals het openbaar vervoer of de gezondheidszorg.

Biometrische systemen

Het gebruik van biometrische systemen voor de identificatie op afstand in openbare ruimten voor rechtshandhaving is in principe ook verboden. Voor bepaalde doelstellingen zijn enkele specifieke uitzonderingen op het verbod opgenomen. Deze zien bijvoorbeeld op het zoeken van slachtoffers van misdaad zoals vermiste kinderen, het voorkomen van levensbedreigende situaties zoals terrorisme en het opsporen, identificeren of vervolgen van een verdachte van een bepaald (zwaarder) strafbaar feit. Maar zelfs in deze situaties zijn er strikte voorwaarden en waarborgen aan het gebruik van biometrische systemen gesteld. Een bekend voorbeeld van een biometrisch systeem is een beveiligingscamera met gezichtsherkenning.

Classificatie van AI-systemen met een hoog risico

Onder de classificatie van AI-systemen met een hoog risico bestaan grofweg twee categorieën.

De eerste categorie bestaat uit AI-systemen die vallen onder de EU productwet- en regelgeving zoals opgenomen in bijlage II en waarvoor een conformiteitsbeoordelingsprocedure door een derde partij moet worden uitgevoerd. Bijlage II heeft bijvoorbeeld betrekking op machines, persoonlijke beschermingsmiddelen, medische hulpmiddelen en medische hulpmiddelen voor in-vitrodiagnostiek.

De tweede categorie betreft AI-systemen die specifiek zijn opgenomen in bijlage III. Dit zijn AI-systemen die gebruikt worden op het gebied van biometrische identificatie en categorisering van natuurlijke personen, beheer en exploitatie van kritieke infrastructuur, rechtshandhaving en rechtsbedeling en democratische processen. De risico’s van deze AI-systemen hebben zich al geopenbaard of zullen dat naar verwachting op korte termijn doen. Bijlage III kan door de EC worden bijgewerkt aan toekomstige AI-toepassingen.

Deze AI-systemen met een hoog risico moeten voldoen aan aanvullende voorschriften en een conformiteitsbeoordelingsprocedure doorlopen. De aanvullende voorschriften bestaan uit een systeem van risicobeheer, data en databeheer, technische documentatie, registratie, transparantie en informatievertrekking aan gebruikers, menselijk toezicht en nauwkeurigheid, robuustheid en cyberbeveiliging. Achtergrond hiervan is om de risico’s te beperken die niet door andere productwet- en regelgeving worden aangepakt. Bij de naleving wordt niet alleen rekening gehouden met de functie van een AI-systeem, maar ook met het doel waarvoor het wordt gebruikt.

Advocaat gespecialiseerd in artificiële intelligentie

MAAK Advocaten is een gespecialiseerd advocatenkantoor in Amsterdam met een focus op bedrijven binnen de sector maakindustrie. Onze advocaten zijn specialisten op het gebied van (EU) productregelgeving en CE-markering en adviseren zowel Nederlandse als internationaal opererende maakbedrijven zoals toeleveranciers, fabrikanten, gemachtigden importeurs, distributeurs en groothandelaren.

Wilt u juridisch advies inwinnen over de mogelijke gevolgen voor uw onderneming van het voorstel voor een AI-verordening of andere geldende en toepasselijke EU productwet- en regelgeving, geharmoniseerde normen of nationale regels? Of heeft uw bedrijf behoefte aan ondersteuning bij een geschil met een handelsrelatie, een toezichthouder of gerelateerde vraagstukken? Neem dan contact op met een van onze advocaat AI-verordening, productregelgeving en CE-markering in Amsterdam.